Il Technology Foresight di NTT DATA

A cura di Alberto Acuto, Foresight & Technology Strategy Specialist

NTT DATA Technology Foresight è un processo annuale che funge da bussola per il futuro: osserva lo stato attuale e l'evoluzione delle società e delle aziende che raggiungono una crescita continua attraverso il massimo utilizzo delle tecnologie informatiche, ed è basato su un'ampia e oggettiva raccolta di informazioni atte a rivelare le tendenze future. Una sezione introduttiva analizza e conferma il rapporto tra società, business e IT, mentre una sezione sui trend tecnologici dettaglia la direzione in cui si sta evolvendo l'informatica e fornisce un'idea sulle future strategie aziendali.

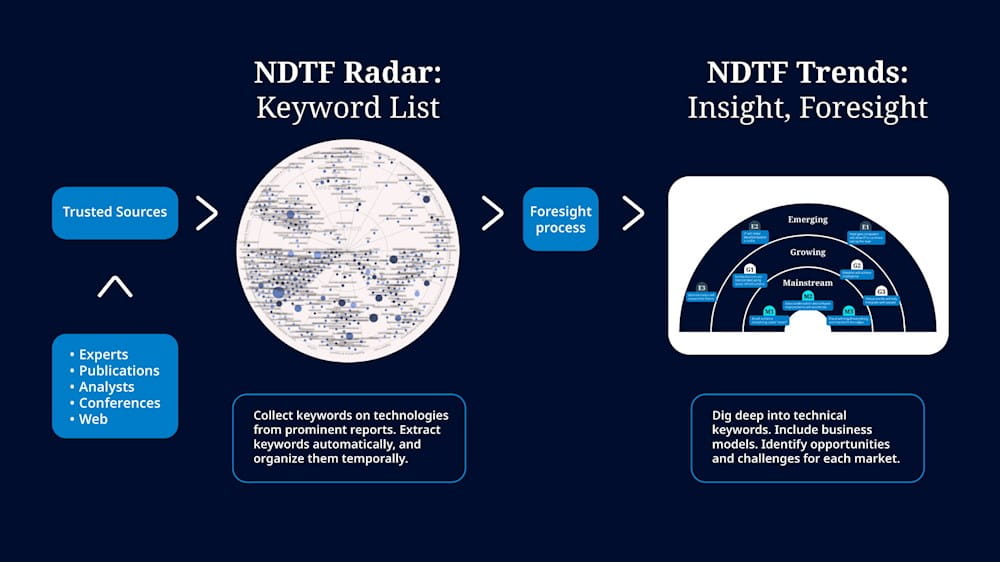

La nostra metodologia di previsione combina l'uso di strumenti di automazione e di intelligenza artificiale per ottenere una visione intermedia da fonti selezionate e affidabili, cui segue una sintesi tradizionale basata sull'esperienza sul campo dei nostri esperti.

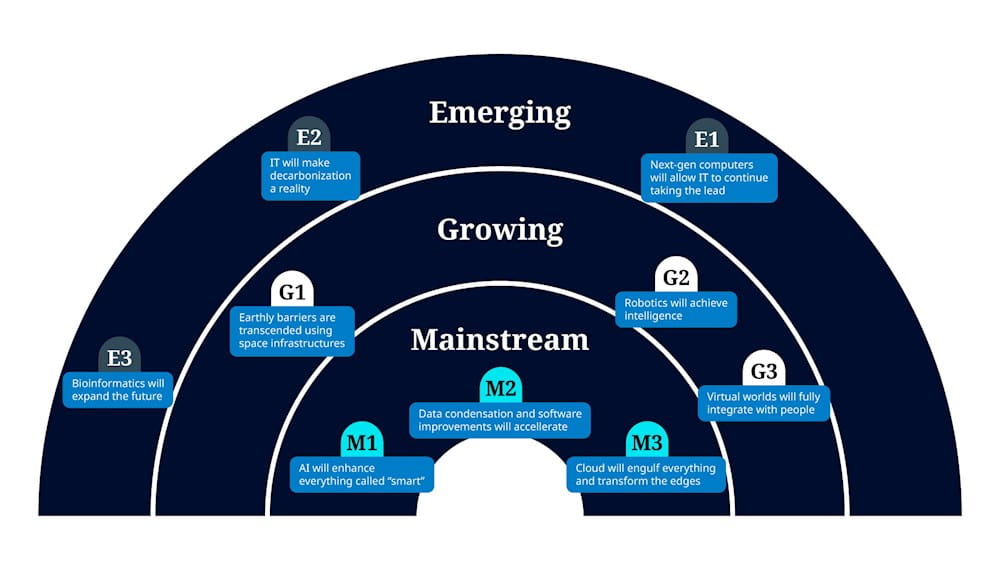

L’analisi conduce all’identificazione di trend di alto livello divisi in tre categorie, in relazione alla maturità delle tecnologie in gioco:

- Mainstream: le tecnologie innovative più mature e al centro dell’odierna competizione. Il loro modello di business è chiaramente definito, e il loro tasso di evoluzione è predicibile con una certa accuratezza.

- Growing: le tecnologie che prevediamo diventino “mainstream” nell’arco di tre/cinque anni. Il modello di business per queste tecnologie è ancora in fase di adattamento, ma il potenziale già evidenziato ci permette di prevedere un mercato stabile in un arco di tempo ben definito.

- Emerging: tecnologie emergenti, attualmente in fase di ricerca e sviluppo. Esprimono un elevato potenziale, ma restano molte incognite riguardanti sia la realizzazione tecnologica, sia i modelli e i volumi del business prodotto. Prevediamo che queste tecnologie possano diventare “mainstream”, apportando un impatto significativo e trasversale sui mercati, in un arco di tempo che va da cinque ai dieci anni.

I trend “mainstream”: AI, dati, cloud

L'AI trasformerà gli oggetti “SMART”

La rivoluzione in atto sull’AI è fondata sull’algoritmo transformer, inventato nel 2017 e che ha visto una crescita esponenziale negli ultimi due anni. Questa tecnica ha stupito i suoi stessi creatori per l’incredibile capacità nella comprensione e creazione di testi, a cui si aggiungono ora le applicazioni al text-to-image e text-to-video, mediante le stesse tecnologie e tramite i cosiddetti “diffusion model”.

La ricerca attuale è focalizzata sulla multimodalità – ossia la possibilità di sviluppare “foundational model” su dati di natura eterogenea, ma interpretati e gestiti in maniera coerente. Un ulteriore tema grande interesse è lo sviluppo di agenti – ossia la capacità dell’AI di compiere azioni complesse in nostra vece. Queste capacità concorrono alla definizione di AGI – “Artificial General Intelligence”, che non va assolutamente confusa con lo sviluppo di un’intelligenza artificiale senziente. L’intelligenza, ossia la capacità di elaborare informazioni per risolvere problemi, non è che una delle caratteristiche che definiscono l’essere umano. Non dovremo stupirci se una futura AGI surclasserà l’essere umano nella sua capacità di risolvere problemi, così come non ci stupiamo che un robot industriale possa lavorare con maggiore forza e precisione, o che un’automobile raggiunga velocità per noi impossibili. È importante mantenere l’attuale dibattito sull’avvento di una “super-human intelligence” nell’ambito di queste considerazioni, e ricordarsi che, almeno allo stato attuale, non vi è nessuna indicazione concreta che i modelli di AI possano dare luogo all’emergere di autoconsapevolezza e volontà.

Abbiamo categorizzato questo trend già come “mainstream”, in virtù della disponibilità di tecnologie e servizi. Tuttavia, esso è destinato ad avere un’ulteriore crescita esponenziale nei prossimi anni – crescita della quale è difficile stimare la portata.

Occorre definire scenari ipotetici, e identificare quegli aspetti delle nostre vite e del nostro lavoro che verranno radicalmente mutati. Verosimilmente, l’AGI è “dietro l’angolo”, e andrà a ridefinire profondamente la nostra interazione con la tecnologia.

I primi oggetti tecnologici che subiranno questo cambiamento saranno i device smart (smartphone, wearable, dispositivi per la domotica, automobili, robot). Le aziende con una grossa componente di Customer Experience devono tenere traccia degli sviluppi e sperimentare massicciamente.

Accelerazione nella qualità di dati e software

Software e dati da una parte, e business dall’altra, hanno un rapporto di crescita bidirezionale. I primi stanno ormai modellando la crescita del business, mentre quest’ultimo fornisce enormi quantità di dati preziosi provenienti dal mondo reale.

Ci aspettiamo un’accelerazione nel modo in cui questi due asset fondamentali (dati e software) vengono ottimizzati. Siamo da tempo abituati a considerare il tema dell’ottimizzazione in ambito IT, sia in termini di software che di hardware. L’idea che l’ottimizzazione significhi riduzione dello spreco, velocizzazione e miglioramento della qualità è alla base dei concetti di DevOps e Continuous Delivery.

L’applicazione di questi principi al mondo dei dati, per migliorarne la qualità e avviare processi ben ingegnerizzati e il più possibile automatizzati, è al cuore della nozione di MLOps – tecnica ormai matura e ampiamente utilizzata.

Non solo è essenziale un’automazione del processo complessivo di sviluppo: ci aspettiamo un ruolo sempre più rilevante della Generative AI nella catena di produzione del valore – e questo in ogni business, anche non prettamente tecnologico.

Grazie all’AI, prevediamo anche un’estensione del perimetro coperto da queste pipeline tecnologiche – ben al di là dei consueti “Development” e “Operations” coperti dal DevOps in ambito IT, per includere anche il mondo del design e della strategia. È possibile prevedere un substrato univoco e fortemente supportato dalla tecnologia, che parte dalla definizione strategica (attraverso il foresight: “Find the Right Problem”, spazio delle opportunità) e prosegue in maniera lineare e con una rapida ciclicità al design (“Design the Right Thing”, spazio problema-soluzione) e infine alla realizzazione (“Make Things Right”, spazio soluzione-mercato).

Possiamo spingerci a coniare un nuovo termine per definire una tale pipeline tecnologica estesa a stakeholder tradizionalmente distinti e caratterizzati da prassi e linguaggi eterogenei (“StratOps”, un processo di innovazione strutturato che va dalla strategia alle operations, passando per il design e lo sviluppo tecnologico). Ci aspettiamo che l’incremento del supporto tecnologico digitale a una tale catena allargata non porti solo a un efficientamento del processo complessivo, ma anche a una sua migliore resilienza e continuità nel tempo.

Il Cloud avvolgerà tutto e trasformerà l’Edge

Il modello Cloud è ormai pienamente consolidato, a prescindere dall’utilizzo di infrastrutture e servizi di terze parti (cloud pubblico o privato).

Le evoluzioni attuali sono:

- Il consueto ricorso all’ottimizzazione, finalizzata ora anche all’abbattimento dell’impatto ambientale, oltre che dei costi operativi.

- Un’estensione dei servizi, per includere ad esempio capacità di calcolo ad alte prestazioni (HPC) su richiesta – precedentemente appannaggio delle grandi strutture centralizzate di supercalcolo (supercomputer).

- Lo sviluppo del rapporto Cloud/Edge, dove ci aspettiamo l’emergere di un intero nuovo spettro di business: il cloud per il consolidamento di processi core con tecnologie efficienti dal punto di vista energetico; l’edge come il luogo dove grandi quantità di dati sono acquisiti e gestiti in misura sempre maggiore, e i servizi erogati all’utente finale.

L’enfasi è sull’importanza delle infrastrutture, un tema sempre più ricorrente e centrale: il vero business, e dunque la vera competizione, si giocheranno in quest’arena.

Data privacy e sicurezza nazionale avranno un ruolo preminente nei cloud pubblici. Stiamo assistendo a un declino della globalizzazione, e la possibile nascita di “cloud sovrani”, con relative opportunità e sfide, dev’essere attentamente seguita.

I trend “growing”: space economy, robot e mondi virtuali

Le barriere geografiche verranno trascese dalla Space Economy

La nascita della space economy, ossia un utilizzo commerciale e accessibile a costi contenuti di oggetti orbitali, è principalmente un tema infrastrutturale.

In questa sezione stiamo esaminando trend che definiamo come “border-transcending”, ossia che consentono alle aziende di travalicare confini tradizionalmente posti al loro business. In questo caso, ci riferiamo a reali confini geografici, che vengono totalmente superati dai satelliti.

Le applicazioni vanno dall’osservazione (meteorologia, scienze ambientali, agricoltura, pianificazione del territorio, trasporti, protezione civile) alle comunicazioni (accesso personale alla banda larga in maniera realmente indipendente dalla posizione) alla produzione di energia (solar farm orbitanti con trasmissione di energia a terra tramite laser – tecnologia in fase di sviluppo nei laboratori NTT).

I casi d’uso associati a queste applicazioni sono potenzialmente innumerevoli, e dovrebbero essere esplorati in dettaglio in tutti i settori economici.

I rischi associati alla space economy dovrebbero pure essere valutati attentamente: avvento di attori monopolisti, resilienza e sicurezza dell’infrastruttura, costi reali di gestione.

I robot acquisiranno intelligenza

Alcuni osservatori si spingono ad affermare che il 2024 sarà l’“anno dei robot”. Più realisticamente, l’avvento della Generative AI ha aggiunto un ulteriore tassello al puzzle della robotica, in termini di comunicazione con l’essere umano e di comprensione reale del mondo circostante (non solo, dunque, la sua percezione). Ciò si aggiunge ai notevoli progressi compiuti nell’ingegneria robotica e nei metodi di apprendimento per rinforzo.

Certamente gli attuali robot industriali, programmati per eseguire compiti specifici, saranno affiancati da “oggetti autonomi” in grado ci compiere azioni in ambienti fisici non strutturati: si va da robot di servizio, ai veicoli autonomi terrestri (Autonomous Ground Vehicles – AGV), fino ai sistemi avanzati di guida assistita (Advanced Driver Assistance Systems – ADAS).

L’addestramento dei robot autonomi dà luogo a una forte multidisciplinarità: la virtualizzazione di robot e ambienti reali nel metaverso, la creazione di ambienti sintetici di addestramento tramite la Generative AI, il miglioramento delle tecniche di apprendimento per rinforzo.

Prevediamo che l’adozione su vasta scala di robot autonomi sarà preceduta da una lunga fase di indirizzamento delle problematiche di sicurezza, legali ed etiche.

Mondi virtuali integrati con le persone

La definizione stessa di metaverso non è univoca e comprende diverse declinazioni: esperienze immersive (contenuti AR e VR, multicanalità), mondi virtuali (gemelli digitali) e tecnologie di decentralizzazione (blockchain, web 3.0).

Di queste, possiamo affermare che solo la simulazione digitale in ambito industriale (Digital Twins, Industrial IoT, Industrial Metaverse) ha sinora mostrato un’accettazione convinta e senza riserve.

Le esperienze immersive offerte dalla VR, aventi sicuramente un grande potenziale nell’intrattenimento come nella formazione, sono attualmente viziate dall’immaturità tecnologica dei dispositivi, che comporta alti costi e scarsa ergonomia.

Tuttavia, ci si può domandare se non ci sia dell’altro alla base di un’accoglienza generale indiscutibilmente “tiepida” di queste tecnologie, considerato l’immancabile “effetto wow” che esse provocano. Indubbiamente, la reazione psicologica del trovarsi improvvisamente immersi in un altro mondo, per giunta con percezioni sensoriali incongrue, viene spesso riportata come “pesante” – indice di una intrinseca innaturalezza dell’esperienza. Un’attenta riflessione su questi aspetti si rende indubbiamente necessaria.

Le tecnologie di maggiore e duraturo successo sono quelle che tendono a diventare trasparenti e scomparire dai nostri occhi. Le tecnologie wireless ne costituiscono un esempio eclatante: si tratta di tecnologie che offrono i loro servizi senza avere un impatto sul nostro ambiente psicologico naturale. Al loro opposto, troviamo tecnologie molto intrusive, come i social network o lo stesso onnipresente smartphone: il principio della “naturalezza dell’interfaccia” dei nuovi dispositivi indossabili basati sull’AI che si affacciano sul mercato, va proprio in questa direzione, e costituisce una tendenza da seguire con molta attenzione.

I trend “emerging”: IOWN, decarbonizzazione e bioinformatica

La prossima generazione di computer

Menzionavamo in precedenza il ruolo centrale delle infrastrutture negli scenari che si vanno a delineare. Queste sono principalmente infrastrutture di calcolo e comunicazione. Le attuali architetture dei processori stanno raggiungendo limiti fisici invalicabili. L’architettura di Von Neumann ha ancora parecchio da esprimere – l’efficienza mostrata dai recenti processori lo dimostra – ma il rapporto fra costi di sviluppo e prestazioni sta decollando.

Questa problematica sta emergendo proprio in un momento storico in cui possiamo prevedere con certezza una crescita esponenziale nelle richieste di prestazioni di calcolo e comunicazione.

Al contempo, nuove tecnologie stanno emergendo – ad esempio quelle basate sulla fotonica, che utilizzano la luce non solo nella comunicazione ottica, ma in maniera pervasiva fra trasmissione e processamento delle informazioni. Il programma IOWN ne è un esempio concreto.

Inoltre, nuovi paradigmi di calcolo si affacciano sulla scena. Il calcolo quantistico promette un incremento esponenziale delle capacità computazionali, su alcuni domini specifici ma estremamente rilevanti, quali l’ottimizzazione, la simulazione di molecole e l’intelligenza artificiale. I chip neuromorfici, ossia modellati sulle architetture neurali degli esseri viventi, condurranno sicuramente a un’ulteriore rivoluzione dell’intelligenza artificiale, soprattutto in merito ai consumi energetici richiesti.

L’IT come abilitatore della decarbonizzazione

È ormai assodato che il raggiungimento degli obiettivi di abbattimento dell’impatto ambientale passi attraverso un’elettrificazione sistematica della nostra società. Questa è anche una sfida colossale, dal momento che il fabbisogno di energia elettrica durante i prossimi decenni è destinato ad aumentare esponenzialmente.

Questa sfida comporta due obiettivi secondari. Da un canto, l’abbattimento dell’impatto ambientale della produzione di energia, responsabile del 70% delle emissioni di gas serra: chiaramente, elettrificare bruciando i tradizionali combustibili fossili non avrebbe senso, ma va anche raggiunta una sostenibilità economica della produzione di energia. D’altro canto, l’ottimizzazione dei consumi energetici, che passa attraverso un efficientamento radicale del ciclo di produzione/consumo.

In questo quadro, l’IT gioca un ruolo fondamentale – che del resto non è altro che il suo scopo principale di sempre: aumentare le capacità cognitive umane. Questo supporto si esprimerà in contesti cruciali quanto complessi. La ricerca sui nuovi materiali, dalla fotovoltaica alle batterie fino alla sostituzione del rame per le trasmissioni elettriche. Lo sviluppo di smart grid, che pone problemi molto complessi di ottimizzazione e previsione. La sfida ingegneristica posta dai reattori nucleari di nuova generazione, sia a fissione che a fusione, dove l’intelligenza artificiale giocherà un ruolo chiave. E chiaramente, lo sviluppo di nuove tecnologie per l’IT stesso, delle quali abbiamo già accennato.

Il ruolo futuro della bioinformatica

Le potenzialità della bioinformatica sono apparse compiutamente nel corso della pandemia: lo sviluppo di vaccini di nuova generazione, che avrebbe comportato anni di ricerca e sviluppo con tecniche tradizionali, è stato compresso in mesi, anche grazie all’utilizzo di nuovi metodi computazionali per il sequenziamento e la modellizzazione.

L’apporto dell’IT è anche metodologico: la bioinformatica sta trasformando un processo tradizionalmente basato sull’esperienza e intuizione umana, e su prove ed errori, in un processo ingegnerizzato guidato dai dati e dalla teoria, connotato da elevati gradi di certezza, riproducibilità e ciclicità rapida tipici degli sviluppi digitali. Questa è una tendenza che troverà applicazione in molti altri contesti ad elevato contenuto cognitivo, ma tradizionalmente meno legati all’IT.

La bioinformatica può avere un ruolo fondamentale anche nella sostenibilità ambientale – si pensi al tema dell’assorbimento di CO2 e allo sviluppo di tecnologie agricole innovative.

Si sta inoltre verificando una nuova suddivisione dei ruoli tra Big Pharma e le startup biotecnologiche. Molte nuove molecole e tecnologie terapeutiche vengono inizialmente sviluppate da piccole aziende biotecnologiche, e in seguito le grandi aziende farmaceutiche producono su grande scala le terapie risultanti e commercializzano il prodotto.

Megatrend emergenti

In NTT DATA, il processo annuale di Technology Foresight è attivo ininterrottamente da più di dieci anni: le prime sperimentazioni risalgono infatti al 2012, e l’attuale formato si è consolidato nel 2014. Ciò ci consente di analizzare l’evolversi delle tendenze su un arco di tempo decennale, alla ricerca di schemi perduranti e meno influenzati da contingenze tecnologiche o di mercato.

I “megatrend” sono cambiamenti a lungo termine, pervasivi e persistenti nei valori, nelle attitudini e nei comportamenti della società, che possono avere un impatto significativo sulle aziende e sui mercati. Questi trend sono spesso guidati dalla tecnologia e da forze culturali ed economiche più ampie, e possono richiedere anni per svilupparsi appieno. Ad esempio, l'incremento dell'attenzione verso la sostenibilità e il consumismo etico, l'ascesa del commercio elettronico e degli acquisti online, o il passaggio al lavoro remoto e al nomadismo digitale sono esempi di megatrend. I seguenti sono tre megatrend tecnologici da noi rilevati nel corso dell'ultima decade:

- Maggiore affinità con gli esseri umani: la nostra interazione con le tecnologie digitali si espande e al contempo diviene meno intrusiva (in termini di sicurezza, trasparenza, interazione naturale).

- Incremento della potenza di calcolo: le capacità computazionali a nostra disposizione continuano a crescere, divenendo progressivamente più sostenibili.

- Tutto diventa interconnesso: il valore generato dalle persone, dagli oggetti e dai servizi risiede in misura sempre maggiore nella loro mutua interconnessione.

Riteniamo che un’attenta identificazione e valutazione dei megatrend costituisca un passaggio obbligato nella formulazione di strategie a lungo termine. Una tale analisi deve accompagnare un’identificazione quanto più precoce delle tendenze emergenti, e l’elaborazione di scenari alternativi volti a esplorare le possibili evoluzioni di queste tendenze, in rapporto al mondo circostante. Prevedere il futuro è sempre impossibile, e oggi più che mai. Ma occorre ricordare che ogni grande rivoluzione nasce da una piccola scintilla. L’identificazione di questi “segnali deboli” (“weak signals”) costituisce un momento fondamentale nella disciplina dello Strategic Foresight, che NTT DATA promuove attivamente al suo interno e presso i propri clienti.